Große Sprachmodelle wie ChatGPT und Co. haben die Entwicklung der Künstlichen Intelligenz revolutioniert und finden in immer mehr Bereichen Anwendung. Doch was genau sind diese Large Language Models und wie funktionieren sie?

Der weltweite Markt für Künstliche Intelligenz ist im Jahr 2024 sprunghaft auf mehr als 184 Milliarden US-Dollar angestiegen. Das entspricht einem Plus von fast 50 Milliarden US-Dollar im Vergleich zum Vorjahr. Prognosen zufolge könnte sich dieses enorme Wachstum fortsetzen und im Jahr 2030 einen Wert von 826 Milliarden US-Dollar erreichen.

Künstliche Intelligenz hat dabei vor allem durch die fortschrittlichen Entwicklungen im Bereich der Large Language Models (LLMs) profitiert. Diese großen Sprachmodelle verstehen menschliche Sprache und sind darauf trainiert, diese auch auszugeben.

Sie können beispielsweise Texte analysieren und zusammenfassen, Antworten formulieren oder kreative Inhalte erzeugen. Doch wie genau funktionieren diese Modelle, wo werden sie eingesetzt, und welche Herausforderungen bringen sie mit sich?

Was sind Large Language Models?

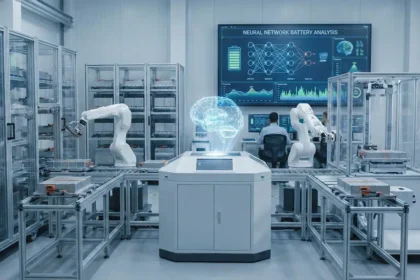

Bei einem LLM handelt es sich um eine Künstliche Intelligenz, die mit großen Mengen an Textdaten trainiert wird. Das Ziel dieses Trainings ist es, dass KI-Sprachmodelle ähnlich wie Menschen in der Lage sind, Texte zu verstehen und auch selbst zu erzeugen. Die Grundlage dafür bilden neuronale Netzwerke, dank der LLMs komplexe Muster in Sprache erkenne und so auch kontextbezogen antworten können.

Bekannte Beispiele für Large Language Models sind ChatGPT von OpenAI, Llama von Meta und Gemini von Google. Diese Sprachmodelle vereinen bestimmte Merkmale wie genrealistisches Wissen. Sie haben also ein Verständnis für besonders viele Themen und sind nicht auf nur eines spezialisiert. Aus diesem Grund können sie auch Antworten zu zahlreichen Themengebieten liefern.

Das ermöglicht den LLMs unter anderem das Merkmal der Skalierbarkeit. Denn da sie Milliarden von Parametern enthalten, sind sie in der Lage, sprachliche Zusammenhänge umfangreich zu erfassen. Außerdem sind sie mit einem Kontextverständnis ausgestattet. Sie können Texte analysieren, Kontext erfassen und zusammenhängende Antworten ausgeben.

Wo werden LLMs eingesetzt?

Large Language Models wie ChatGPT und Co. sind also vor allem auf die Texterstellung und -bearbeitung ausgelegt. Sie finden etwa Anwendung bei der Erstellung von Texten wie E-Mails oder Übersetzungen.

Auch in vielen Unternehmen sind große Sprachmodelle inzwischen beliebt – beispielsweise im Kundenservice. Zahlreiche Firmen setzen auf Chatbots und virtuelle Assistenten, die einfache Fragen verstehen und beantworten können.

LLMs beherrschen allerdings nicht nur die menschliche Sprache und können grammatikalisch korrekte und gut strukturierte Texte erstellen. Auch diverse Programmiersprachen gehören zu ihrem Portfolio, weshalb sie zunehmend auch als Programmierhilfen eingesetzt werden.

Welche Grenzen haben Large Language Models?

Trotz ihrer Leistungsfähigkeit und des fortgeschrittenen Verständnisses haben LLMs Grenzen und Einschränkungen. Denn Large Language Models sind darauf ausgelegt, ihre Ergebnisse anhand der Wahrscheinlichkeiten des nächsten Tokens auszugeben. Dabei wird der tatsächliche Wahrheitsgehalt nicht immer berücksichtigt.

Denn LLMs mangelt es unter anderem an echtem Verständnis. Sie verarbeiten die eingegebene Sprache auf der Grundlage von Mustern in Daten. Ein tatsächliches menschliches Verständnis oder Erfahrungen, aus denen sie schöpfen können, fehlt ihnen.

Das kann bei Sprachmodellen auch zu Halluzinationen, also zu falschen Aussagen führen. Denn die Systeme nehmen keine eigene Faktenprüfung vor und benötigen für wissenschaftliche, medizinische oder rechtliche Inhalte enorm viel Kontext, beispielsweise durch zahlreiche Textdokumente. Fehlt dieser Kontext, kann es zu widersprüchlichen Aussagen kommen.

Problematisch beim Training von LLMs sind Fehleinschätzungen und Vorurteile. Denn da viele Sprachmodelle mithilfe von großen Datensätzen aus dem Internet trainiert werden, können sie bestehende Vorurteile und Stereotype übernehmen und verstärken. Auch Fehlinformationen können so gezielt gestreut werden, wie erst kürzlich eine Untersuchung von Newsguard gezeigt hat.

Auch interessant: