Halluzinationen sind bei KI-Modellen keine Seltenheit. Ein Forscher hat nun aber einen Ansatz gefunden, um großen Sprachmodellen genau diese abzugewöhnen. Dadurch lässt sich KI deutlich stärker an überprüfbare Fakten binden – und liefert so verlässlichere Antworten.

Halluzinationen stellen ein bekanntes Problem bei der Nutzung von KI-Modellen dar. Das Phänomen bezeichnet Fälle, in denen Sprachmodelle Informationen erfinden oder Fakten falsch darstellen.

Sie liefern also falsche Antworten, die – dank eines großen Selbstbewusstseins – jedoch absolut überzeugend formuliert sind. Das kommt vor, da KI-Modelle nicht über echtes Wissen verfügen, sondern lediglich Wahrscheinlichkeiten berechnen und so ihre Antworten zusammensetzen.

Besonders problematisch wird das, wenn solche erfundenen Inhalte in sensiblen Bereichen wie Medizin, Recht oder Nachrichtenverbreitung ungeprüft übernommen werden. Sie können zu Fehlinformationen führen und das Vertrauen in KI-gestützte Systeme untergraben.

Ein Forscher der University of Arizona hat nun aber eine Möglichkeit entwickelt, genau dieses Problem zu umschiffen. Diese Technik hilft KI-Systemen zu erkennen, wann ihre Vorhersagen möglicherweise unzuverlässig sind.

Kann dieses Vorgehen KI Halluzinationen austreiben?

Grund für die Halluzinationen von KI-Modellen ist meist noch nicht einmal Unwissen der Systeme. Das haben Forscher vom Technologischen Institut für Israel ermittelt. Demnach kodieren die Systeme zwar die richtige Antwort, erzeugen aber nach außen hin eine falsche Antwort.

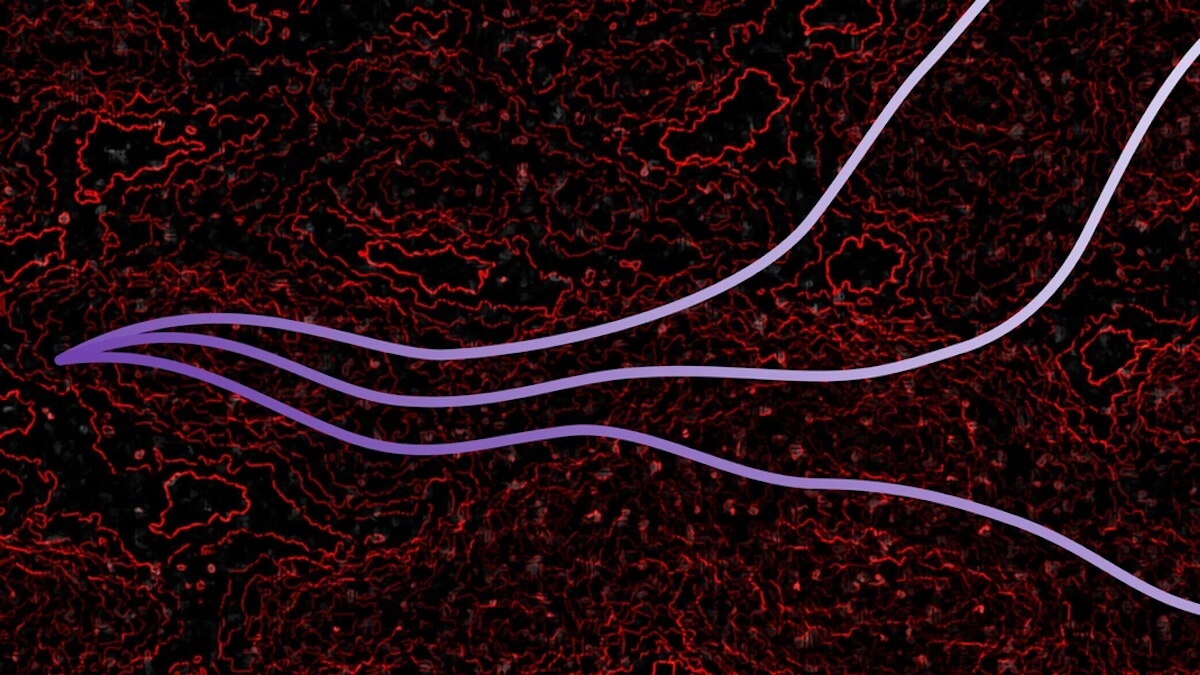

Peter Behroozi, Associate Professor am Steward Observatory der University of Arizona, hat hierfür nun aber eine Lösung gefunden. Hierfür hat er eine Methode entwickelt, die das sogenannte Raytracing adaptiert. Dabei handelt es sich um ein Rendering-Verfahren in der Computergrafik, das beispielsweise zur Erzeugung realistischer Beleuchtung in Animationsfilmen verwendet wird.

Mit Hilfe des Raytracings konnte Behroozi nun komplexe mathematische Räume erforschen, in denen KI-Modelle operieren. „Aktuelle KI-Modelle leiden unter falschen, aber selbstbewussten Ergebnissen“, erklärt der Astronom. „Es gibt viele Beispiele für neuronale Netze, die ‚halluzinieren‘ oder nicht existierende Fakten, Forschungsarbeiten und Bücher erfinden, um ihre falschen Schlussfolgerungen zu untermauern.“

Das führe zu echtem menschlichem Leid, so Behroozi. Er bringt Beispiele wie fehlerhafte medizinische Diagnosen, abgelehnte Mietanträge oder fehlgeschlagene Gesichtserkennung an.

Nebenprodukt der Forschung zur Entstehung von Galaxien

Behroozi forscht eigentlich zur Entstehung von Galaxien. Die Entdeckung zur Minimierung von Halluzinationen bei KI wurde durch eine Hausaufgabe aus der computergestützten Physik ausgelöst. Diese hatte ein Student in seine Sprechstunde mitgebracht.

So wurde der Forscher auf das Raytracing aufmerksam. „Anstatt dies in drei Dimensionen zu tun, habe ich herausgefunden, wie man es für eine Milliarde Dimensionen umsetzen kann“, erklärt Behroozi.

Dabei setzt er für seine neu entwickelte Methode auf das Bayessche Sampling. Es handelt sich dabei um ein statistisches Verfahren, das Wahrscheinlichkeiten auf Basis neuer Daten fortlaufend aktualisiert.

Anstatt sich auf die Vorhersage eines einzigen Modells zu verlassen, trainiert das Bayessche Sampling Tausende verschiedener Modelle mit denselben Daten unter Verwendung eines speziellen mathematischen Ansatzes, der es ihnen ermöglicht, die Vielfalt möglicher Antworten zu erkunden.

So werde laut Behroozi nicht ein einzelner Experte konsultiert, sondern „die gesamte Bandbreite an Experten“. Bei Themen, mit denen sich diese Experten nicht auskennen, erhalte man eine ganze Reihe an Antworten. Daraus lasse sich schließen, „dass man den Ergebnissen nicht trauen sollte“.

Behroozis Methode würde diesen Systemen ermöglichen zu erkennen, wann sie unsicher sind. Im Wesentlichen verleiht sie ihnen also die Fähigkeit zu wissen, wann sie etwas nicht wissen.

Auch interessant: