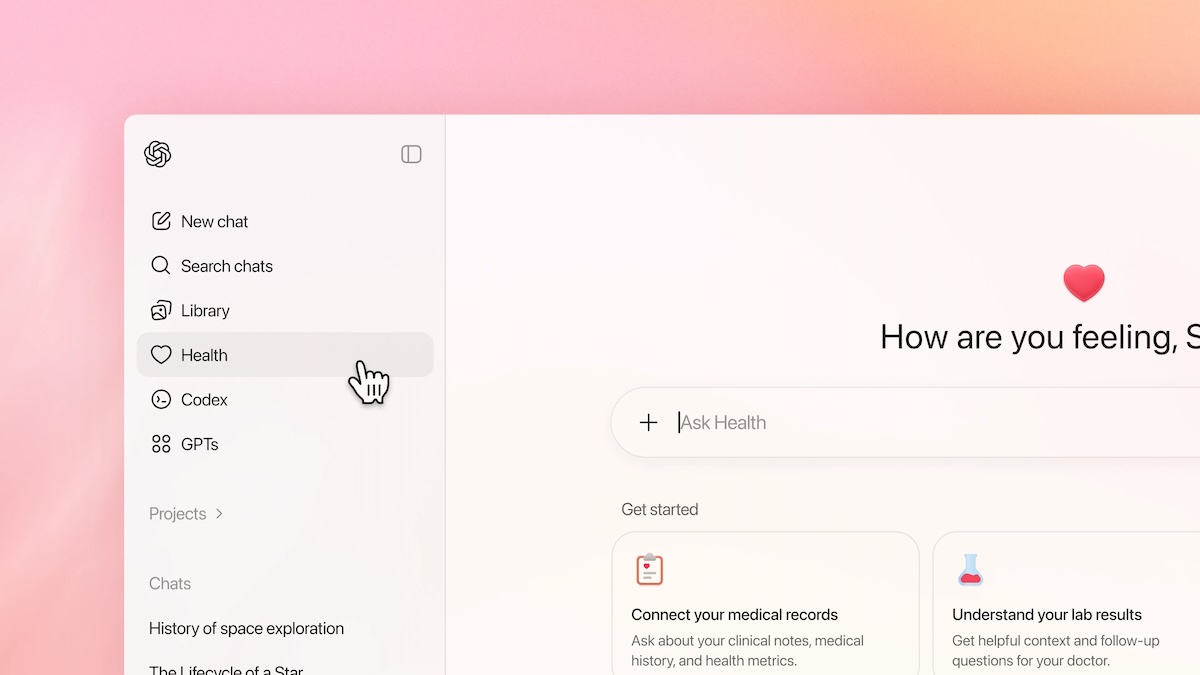

OpenAI fügt ChatGPT einen neuen Gesundheits-Tab hinzu, über den Nutzer elektronische Krankenakten hochladen und Verbindungen zu Gesundheits- und Fitness-Apps herstellen können. Die Reaktionen auf ChatGPT Health fallen jedoch gemischt aus. Eine kommentierende Analyse.

Was ist ChatGPT Health?

- ChatGPT Health ist ein speziell isolierter Bereich innerhalb des Chatbots. Nutzern sollen dort Konversationen zu Gesundheitsthemen führen können, ohne dass sich sensible Daten mit regulären Chatverläufen vermischen. Laut OpenAI kann Health Gesundheitsdaten auswerten und über allgemeine Ratschläge hinaus erkennen können, wann ärztliche Hilfe erforderlich ist.

- Das System wurde den Angaben zufolge mit über 260 Ärzten entwickelt, um Antworten zu Gesundheitsfragen zu analysieren und sicherzustellen, dass ChatGPT medizinisch plausible und korrekte Antworten liefert. Die Funktion lässt sich mit Fitness- und Gesundheitsdaten aus Apps wie Apple Health, Weight Watchers oder Peloton verbinden. Die Integration von elektronischen Patientenakten ist zunächst nur in den USA möglich.

- OpenAI zufolge konsultieren jede Woche Millionen Nutzer ChatGPT zu Gesundheitsfragen. Das Problem: Aufgrund von sogenannten Halluzinationen spucken KI-Chatbots immer wieder unsinnige bis komplett falsche Antworten aus. Bei Gesundheitsthemen kann das verheerende Folgen haben, wie erst kürzlich Google wieder unter Beweis stellte.

OpenAI wälzt Verantwortung auf Nutzer ab

OpenAI betont, dass ChatGPT Health trotz der engen Zusammenarbeit mit Ärzten keine Diagnosen stellen oder Behandlungen empfehlen darf. Das Tool soll offiziell lediglich zur Information und Vorbereitung von Arztbesuchen dienen.

Das ist vor allem rechtlich relevant, da OpenAI ChatGPT Health in den USA als Verbraucherprodukt einstufen lassen hat. Damit fällt die Funktion nicht unter die strengen Datenschutzgesetze für das Gesundheitswesen. Das entbindet OpenAI von gewissen Haftungsrisiken und verlagert die Verantwortung vor allem auf die Nutzer.

Innerhalb der EU wäre das sicher nicht möglich – und das ist auch gut so. Denn trotz Verbesserungen und ärztlichen Analysen sind Falschinformationen in Form von KI-Halluzinationen keinesfalls komplett ausgeschlossen. In puncto Datenschutz gibt es ebenfalls Bedenken.

OpenAI bietet zwar eine Zweck-Verschlüsselung an, aber eben keine Ende-zu-Ende-Verschlüsselung, wie sie bei Messenger-Diensten üblich ist. Heißt konkret: Es besteht zwar ein Schutz vor Fremdzugriffen. OpenAI kann die Daten jedoch einsehen.

Stimmen

- Fidji Simo, CEO of Applications bei OpenAI, in einem Blogbeitrag: „ChatGPT Health ist ein weiterer Schritt, um ChatGPT zu einem persönlichen Super-Assistenten zu machen, der Sie mit Informationen und Tools dabei unterstützt, Ihre Ziele in allen Bereichen Ihres Lebens zu erreichen. Wir stehen noch ganz am Anfang dieser Reise, aber ich freue mich darauf, diese Tools mehr Menschen zugänglich zu machen.“

- OpenAI-Chef Sam Altman erklärte bereits im Sommer gegenüber CNBC: „Das Gesundheitswesen ist der Bereich, in dem die größten Verbesserungen zu verzeichnen sind. Es macht einen großen Teil der Nutzung von ChatGPT aus. Ich denke, es ist wirklich wichtig, den Menschen bessere Informationen über ihre Gesundheitsversorgung zu geben und ihnen die Möglichkeit zu geben, bessere Entscheidungen zu treffen.“

- Autor und Journalist Aidan Moher spottet in einem Post auf Bluesky: „Was soll schon schiefgehen, wenn ein LLM, das darauf trainiert ist, die Vorurteile der Nutzer zu bestätigen, zu unterstützen und zu fördern, auf einen Hypochonder mit Kopfschmerzen trifft?“

Ein Gesundheitsberater, der ChatGPT niemals sein kann

Da Millionen Nutzer ChatGPT trotz einhelliger Warnungen nach wie vor zu Gesundheitsfragen konsultieren, ist es zunächst einmal begrüßenswert, dass sich OpenAI dem Thema angenommen hat, um den Chatbot zu verbessern.

Doch das Unternehmen suggeriert auch einen Gesundheitsberater, der ChatGPT niemals sein kann. Die externe Aufklärung von Nutzern wird deshalb genauso entscheidend sein, wie die Frage, ob der Chatbot tatsächlich genügend Warnhinweise an den richtigen Stellen ausspuckt und wie er mit hochsensiblen Gesundheitsthemen umgeht.

Dass eine Verarbeitung von ärztlichen Patientendaten in der EU nicht möglich ist, deutet auf regulatorische Hürden hin. Denn: In Deutschland unterliegen Gesundheitsdaten glücklicherweise strengen Verarbeitungsvoraussetzungen. Vermutlich wird OpenAI solche Daten in den USA nutzen, um personalisierte Werbung zu schalten. Vollständiger Datenschutz ist nicht garantiert.

Auch interessant: