Nun ist sie beschlossene Sache: die Urheberrechtsreform. Der Bundestag hat die Gesetzesnovelle beschlossen und damit auch den Weg für die umstrittenen Uploadfilter geebnet. Wir beleuchten, was das für die Netzgemeinde bedeutet.

Am 26. März 2019 hat das Europäische Parlament die neue EU-Richtlinie zum Urheberrecht beschlossen. Nun ist die Urheberrechtsreform auch in Deutschland angekommen: Der Bundestag hat mit den Stimmen von Union und SPD die umstrittene Novelle durchgewunken.

Die Reform nimmt vor allem Tech-Riesen wie Google, Facebook und Twitter ins Visier – beziehungsweise all die Plattformen, auf denen Nutzer:innen Texte, Bilder oder eigene Musikstücke hochladen und teilen.

Diese vom Urheberrecht geschützten Werke sollen durch das neue Gesetz besser geschützt sein. Denn um eventuelle Schadensersatzansprüche aus Urheberrechtsverletzungen müssen sich die Urheber:innen nicht mehr selbst kümmern. Die Gesetzesnovelle nimmt die Plattformen in die Pflicht, aktiv gegen Rechtsbrüche vorzugehen.

Die gesetzliche Grundlage für die umstrittenen Uploadfilter

Die Urheberrechtsreform bringt nun auch ein in der Netzgemeinde stark umstrittenes Thema wieder auf die Agenda: die Uploadfilter.

Diese sind in Artikel 17 der EU-Urheberrechtsreform verankert. Sie übertragen Plattformen wie Facebook, YouTube und Co. die urheberrechtliche Verantwortung für die Inhalte der Nutzer:innen.

So sollen sie entweder gegen Urheberrechtsverletzungen vorgehen oder aber Lizenzen erwerben, damit die Inhalte legal genutzt werden können.

Dieses Vorhaben scheint anhand der Datenmenge, die jede Minute über Social Media ins Netz geblasen wird, schier unmöglich. Zumindest von Menschenhand wäre dieser Beschluss nicht umzusetzen – womit wir bei den Uploadfiltern angekommen wären.

Kein Wunder also, dass der „Einsatz automatisierter Verfahren“ im neuen Gesetz verankert ist.

Die große Angst vor den Uploadfiltern

Eine der größten Sorgen vieler Nutzer:innen dürfte wohl die Zensur sein. Es besteht die Angst, die Plattformen könnten lieber zu viel als zu wenig blockieren – um sich nicht angreifbar zu machen.

Wieder anderen – vor allem der Musikindustrie – geht die Reform nicht weit genug.

Wie funktionieren Uploadfilter?

Meike Laaff bezeichnet die Arbeit der Uploadfilter in der Zeit als „automatisierte Schnipseljagd“. Wird also zum Beispiel ein Video bei YouTube hochgeladen, überprüft der Uploadfilter, „ob darin ein fremdes Werk oder Schnipsel davon enthalten sind.“

Diese „automatisierte Schnipseljagd“ basiert auf der Automatic Content Recognition (ACR) – bei den großen Plattformen ist dieses Verfahren bereits seit Jahren im Einsatz.

Erkennt YouTube in einem Video urheberrechtlich geschütztes Material wie zum Beispiel Musik, wird das Video entweder komplett oder teilweise gesperrt. YouTubes System ContentID untersucht dafür Videos beim Upload und bereits hochgeladene Inhalte.

Wird ein solcher Verstoß erkannt, dürfen Urheber:innen entscheiden, ob sie das entsprechende Video sperren oder lieber an den Werbeeinnahmen mitverdienen wollen.

Doch wie erkennt YouTube einen solchen Verstoß gegen das Urheberrecht?

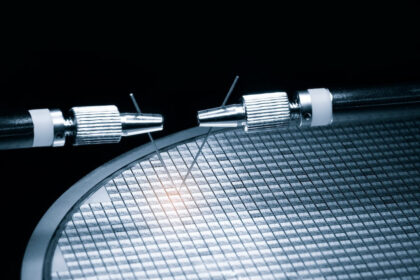

Die Lösung heißt Fingerprinting-Verfahren. Dieses stellt sicher, dass das System auch Elemente erkennt, die nur einen Ausschnitt zeigen oder – wie so oft in YouTube-Videos – nur in einem kleinen Splitscreen ablaufen.

Meike Laaf beschreibt das Verfahren so: „Man berechnet aus einer Datei eine ganz kompakte und doch eindeutige Darstellung, robuste Hashes, die man miteinander vergleicht.“

Das könne bei Audiodateien das Verhältnis der Tonhöhen sein, bei Videos bestimmte Farbverläufe oder der Helligkeitsabgleich von einem Standbild zum nächsten.

Bei einer solchen Analyse entstehen dann zahlreiche Fingerprints, aus denen sich „eine ganze Kette derartiger Hash-Informationen“ ergibt. Das sei kostengünstiger als jeden Upload mit kompletten Musikstücken abzugleichen. Außerdem könne das System so auch Ausschnitte finden.

Was ist, wenn die Technik versagt?

Doch bei den Analysen kommt es immer wieder zu Fehlern. Fraglich ist nun, ab wann die Systeme Alarm schlagen sollen. Das hänge mit den Schwellenwerten zusammen, zitiert Maike Laaf Martin Steinebach, Leiter der Abteilung für Mediensicherheit und IT-Forensik am Fraunhofer Institut für Sichere Informationstechnologie.

„Und je nach Einstellung der Betreiber schlagen die Systeme dann an, wenn sie absolut sicher sind, dass sie eine korrekte Übereinstimmung erkannt haben – oder weitaus früher, sodass sie sehr viel häufiger daneben liegen“, schreibt Laaf.

Ein weiteres Problem stellen Zitate für die automatisierten Filter dar. Hierunter fallen auch Satire und Parodien oder Memes und Gifs.

Das neue deutsche Urheberrecht sieht genau für diese Fälle Einschränkungen vor. Es werde davon ausgegangen, dass es sich bei einem „15 Sekunden langen Schnipsel mit hoher Wahrscheinlichkeit nicht um eine böswillige Raubkopie“ handelt, analysiert Laaf.

Diese Fälle bezeichnet das Gesetz als mutmaßlich erlaubte Nutzung, bei denen der hochgeladene Inhalt zunächst online bleiben kann. Der Rechteinhaber wird informiert und kann dann in einem Beschwerdeverfahren analysieren lassen, ob sein geistiges Eigentum legal oder eben illegal genutzt wurde.

Doch diese Fälle sind dann von den Uploadfiltern ausgenommen. Denn laut dem neuen Urheberrecht muss hier zwingend ein Mensch entscheiden.

Auch interessant: