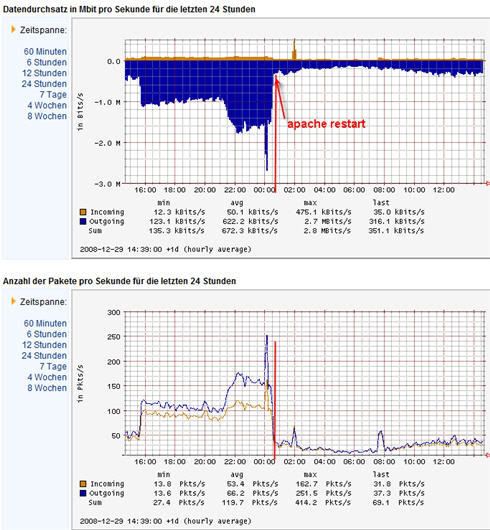

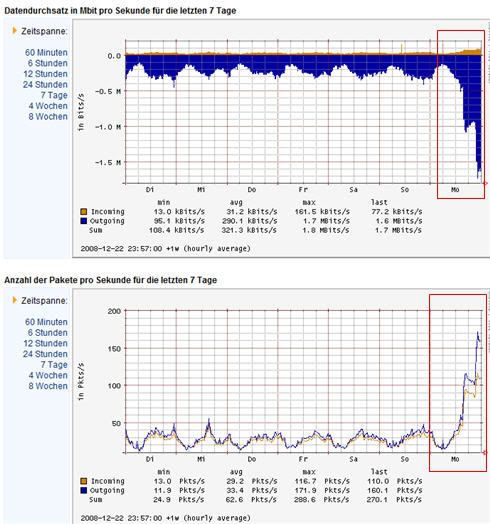

wundere mich heute, warum mein Blog so lahm reagiert. Habe mir über die Strato-Konsole den Trafficmonitor anzeigen lassen und sehe diesen Peak, der sechsmal so hoch ist wie der Durschnitt:

Wie bekomme ich nun raus, was die Quelle des Anstiegs ist? Nein, kenne mich nicht mit Linuxservern aus. Ja, habe einen Admin. Will aber auch lernen:) Was ich weiß: Der Besucherstrom ist heute wie immer, keine Abweichungen von der Norm. Hab jetzt erstmal den Apache-Dienst neu gestartet. Mal schauen, wie lange das hilft. Momentan ist zunächst Ruhe… zunächst…

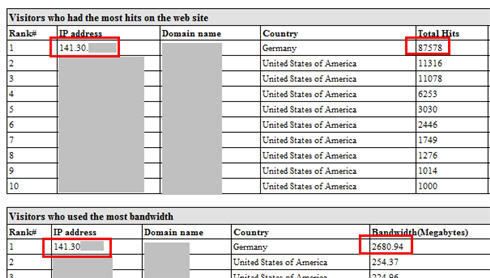

Update: Habe mir die Serverlogs gezogen und zunächst nach auffälligen Aufrufen von bestimmten IPs geschaut. Und gleich ein Treffer, eine IP zieht bisserl viel heute, etwas auffällig

Ein Aufruf der IP ergibt als Quellrechner-Lokation die TU Dresden an. Hm.. werde mal Kontakt aufnehmen zum Admin der Uni, welcher Rechner das genau ist.

Update: Seit dem Neustart des Apache-Dienstes hat sich merkwürdigerweise der „Sauger“ beruhigt. Hätte das nicht wieder hochgehen müssen?? Nur weil ich auf meiner Seite einen Dienst stoppe… merkwürdige Sauger-Software.