hatte vor einiger Zeit über den Einbruch des Google-Traffics beim Living in World of Warcraft Blog berichte (Link zum WoW-Blog)t. Google hat uns anscheinend in die Sandbox geschmissen, was zu einem vehementen Trafficeinbruch führte. Man konnte uns per Google-Suche so gut wie nicht mehr finden. Jan hatte einige Vermutungen angestellt (Hauptannahme: Double Content) und mit Hilfe seiner Tipps habe ich folgende Maßnahmen vor ca. einer Woche ergriffen:

1. in der robots.txt dem Spider den Zugriff auf das Forum verweigert. Das Forum dient uns als Nebenanlaufstelle (intern für die Autoren und Vorschläge/Tipps seitens Lesern). Eine Besonderheit des Forums hat dazu geführt, daß Google tausende von Sites gespidert hatte: Man kann die Beiträge nach verschiedenen Kriterien anzeigen und das hat dann der Spider auch fleissig getan. Zu jedem Forenbeitrag gab es mehrere Links.

2. die Webseite war per URL sowohl über „www….“ als auch ohne „www“ erreichbar. Das hat ebenfalls dazu geführt, daß Google zwei verschiedene Links zu einigen Beiträgen erspidert hatte. Über diesen Eintrag in der .htaccess biege ich alle Aufrufe ohne „www“ so um, daß alle URLs für Living in WoW Beiträge mit einem „www“ vorangestellt werden:

RewriteCond %{HTTP_HOST} !^www.gamersliving.com [NC]

RewriteRule (.*) http://www.gamersliving.com/wowblog/$1 [R=301,L]

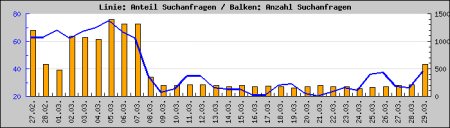

Ich weiss nicht, ob es damit zu tun hat, aber seit gestern stieg die Google-Quote von ca. 20% auf über 40%. Vormals betrug die Google-Quote ca. 70%. Google-Quote? Ja, der Anteil der Besucher, die über Google reinkommen.

Google-Quote mit einem tiefen Tal:

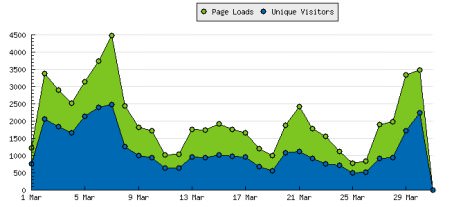

Trafficentwicklung korreliert natürlich stark mit Google:

und das ganze per Statcounter.com Auswertung für März 06:

Auch heute hält die Tendenz an, die Suchanfragen sind immens zu den Vortagen hochgegangen und erreichen alte Zeiten:

Datum Impressions Visits Searches Internals Bots

2006/3/30 4104 2599 1967 901 1

2006/3/29 3308 1525 581 1263 3

2006/3/28 1863 785 208 793 1

2006/3/27 1769 753 203 741 3

2006/3/26 777 465 172 233 4

2006/3/25 715 446 159 196 4

2006/3/24 1037 590 139 351 6

2006/3/23 1376 662 169 531 6

2006/3/22 1613 763 178 663 1

2006/3/21 2291 941 192 1063 1

2006/3/20 1770 835 180 694 6

2006/3/19 958 526 155 290 4

2006/3/18 1143 621 172 358 4

2006/3/17 1598 852 182 533 5

2006/3/16 1498 825 176 504 8

2006/3/15 1678 795 202 648 4

2006/3/14 1390 690 172 590 0

2006/3/13 1496 784 200 546 4

2006/3/12 990 592 209 264 0

2006/3/11 996 611 213 230 0

2006/3/10 1563 803 199 590 3

2006/3/9 1649 830 192 550 3

2006/3/8 2267 1019 352 906 3

2006/3/7 4209 2127 1309 1361 3

2006/3/6 3469 1971 1316 993 0

2006/3/5 2817 1867 1401 496 2

2006/3/4 2242 1477 1038 418 0

2006/3/3 2649 1599 1071 702 1

Ob wir nun wirklich aus der Sandbox draussen sind, ob Google in der Tat Double Content entdeckt hatte, ich weiss es nicht. Kann sein, daß es nur temporäre Ausschläge sind.