Daten sind überall. In unserer vernetzten Welt fallen jede Sekunde riesige Datenmengen an. Jedes Mal, wenn wir unser Telefon entsperren und eine App aufrufen, wird dieser Aufruf in den meisten Fällen geloggt und zur Optimierung des verwendeten Services verwendet. Wie oft habt ihr beispielsweise heute schon euer Telefon in der Hand gehabt und euren Status auf Instagram, Twitter und Co. gecheckt? Wahrscheinlich schon mindestens einmal.

In den meisten Fällen hört man, dass dieser Datenschatz die Welt zu einem besseren Ort machen wird. Städteplaner können herausfinden, an welcher Stelle dringend neue Infrastruktur benötigt wird, Google kann uns anzeigen, ob ein Verkehrsmittel stark besetzt ist oder wir wahrscheinlich einen Sitzplatz bekommen und wir bei Mobilegeeks sehen, welche Themen euch gut gefallen, sodass wir in Zukunft mehr davon bringen können.

Auch, wenn das erst mal gut klingt, sollten wir uns dem folgenden Gedanken hingeben: Steckt in den Daten wirklich so viel Information, dass auf Basis dessen unser zukünftiges Leben positiv beeinflusst werden kann? Oder könnten uns diese Daten sogar gefährlich werden? Man nehme beispielsweise Microsoft, dessen Chatbot plötzlich zur rassistischen Parolenschleuder wurde oder Flickr, das Konzentrationslager als „Dschungel Fitnessstudio“ labelte.

Schauen wir nach Großbritannien, dann haben dort laut einem neuen Bericht 28 Prozent der Angestellten im Technologiesektor davor Angst, dass die Technologien, an denen sie arbeiten, negative Auswirkungen auf unsere Gesellschaft haben. Es ist schön, dass diese Angestellten sich auch über die Schattenseiten der Technik Gedanken machen, eine positive Zukunft steht uns demnach aber nicht bevor.

Ein Bereich, der auch zunehmend in den Vordergrund rückte, ist der Umgang von KI mit Frauen und farbigen Menschen. Ihr habt sicher schon einige Male von dem Problem der Gesichtserkennung gehört, die deutlich besser mit weißen Männern, als mit anderen Menschen umgehen kann. Bisher werden solche Diskussionen heruntergespielt und das Problem als „Bug“ kategorisiert. Aber das kann nicht unsere Lösung auf diesen Missstand sein.

Algorithmen und künstliche Intelligenz können die erhaltenen Daten nur nach objektiven Gesichtspunkten kategorisieren. Damit aber auch wirklich qualitativ hochwertige Datensätze entstehen, sind subjektive Einflüsse unabdingbar. Hier kommen wir zu einem Schlüsselakteur der Entwicklung: dem Menschen. Gerade die Definition darüber, was eigentlich fair ist, kann eine Maschine (noch) nicht entscheiden. Mangelnde Gleichberechtigung, Rassismus und Ausgrenzung werden 1:1 in digitale Bits übertragen. Daher liegt es an den Entwicklern, den Algorithmen das Laufen beizubringen.

Es muss also schnell gehandelt werden. Mit jedem Tag, der vergeht, entstehen weitere Daten, die den falschen Schluss zulassen, dass bestimmte Zielgruppen mächtiger und andere wiederum schwächer sind. Außerdem kann nie davon ausgegangen werden, dass man alles über bestimmte Personengruppen weiß. Denn auch, wenn wir einen Großteil unseres Lebens online verbringen, gibt es doch Geheimnisse, die wir lieber für uns behalten möchten.

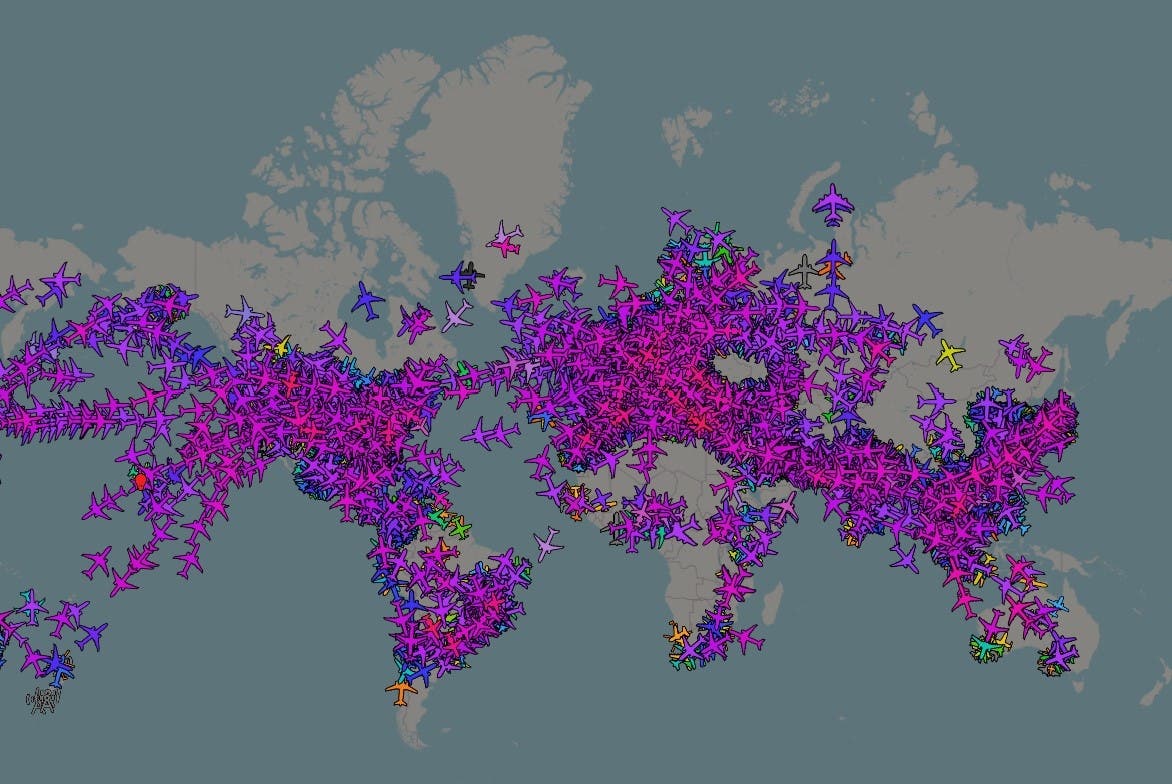

Daten: The Next Web

Mehr Soziales: