KI könnte der Grund dafür sein, dass wir bisher noch keine Aliens getroffen haben. Denn im Rahmen einer Studie erklärt ein Wissenschaftler aus Manchester, wie Künstliche Intelligenz nicht nur die Menschheit, sondern auch außerirdisches Leben bedroht.

Künstliche Intelligenz ist mittlerweile fast allgegenwärtig und sie entwickelt sich rasant weiter. Experten warnen stetig davor, KI nicht zu unterschätzen. Einige bewerten die Gefahren durch die Technologie sogar ähnlich hoch wie die einer Coronoa-Pandemie oder eines Atomkriegs. Eine neue Studie hat sich nun damit beschäftigt, ob Künstliche Intelligenz das Ende für die Menschheit als Spezies bedeuten könnte.

Der Große Filter: Finden wir wegen KI keine Aliens?

Die Studie erschien im Wissenschaftsmagazin Science Direct. Der Titel: „Ist Künstliche Intelligenz der Große Filter, der fortgeschrittene technische Zivilisationen im Universum selten macht?“. Die Abhandlung stammt von Michael Garrett von der Abteilung für Physik und Astronomie der Universität Manchester.

Die Studie handelt vor allem von dem Konzept des sogenannten Großen Filters. Dabei geht es um ein hypothetisches Ereignis oder eine Situation, die intelligentes Leben daran hindert, sich auf anderen Planeten oder im Universum auszubreiten. Der Große Filter könnte zudem für den Untergang dieser Spezies verantwortlich werden.

„Man denke an Klimaveränderungen, Atomkriege, Asteroideneinschläge, Supernovaexplosionen, Seuchen oder eine beliebige Anzahl anderer Ereignisse aus der Schurkengalerie der katastrophalen Ereignisse“, versucht ein weiterer Artikel die Zusammenhänge zu interpretieren. Künstliche Intelligenz könnte ein solcher Großer Filter sein.

Auch Stephen Hawking äußerte bereits vor seinem Tod Befürchtungen, dass eine Künstliche Intelligenz die Menschen vollständig ersetzen könnte:. „Wenn Menschen Computerviren entwickeln, wird jemand KI entwickeln, die sich selbst verbessert und repliziert. Das wird eine neue Form des Lebens sein, die den Menschen übertrifft“, sagte er 2017 gegenüber Wired.

KI als Großer Filter bedroht auch Aliens

Michael Garrett sieht es ähnlich. „Wenn die technologische Singularität erreicht ist, werden Artificial Superintelligence-Systeme die biologische Intelligenz schnell übertreffen und sich in einem Tempo weiterentwickeln, das die herkömmlichen Kontrollmechanismen völlig übersteigt“, erklärt der Wissenschaftler.

Wenn Künstliche Intelligenz zu einer künstlichen Superintelligenz wird, könnte das der Große Filter sein, so Garrett. Denn dann würde sie das biologische Leben, das sie erfunden hat, nicht mehr brauchen.

„Ohne praktische Regulierung gibt es allen Grund zu der Annahme, dass KI eine große Bedrohung für den zukünftigen Verlauf nicht nur unserer technischen Zivilisation, sondern aller technischen Zivilisationen darstellen könnte“, so Garrett. Die unkontrollierte Entwicklung der Technologie könnte demnach dazu führen, dass eine Zivilisation nur eine Lebensdauer von weniger als 200 Jahren haben könnte.

Diese Annahme könnte Garrett zufolge auch erklären, dass wir bisher noch kein außerirdisches Leben gefunden haben. Denn angenommen, es gäbe im Universum Wesen, die genauso schlau sind wie wir, könnten auch sie im gleichen Maße von KI bedroht werden – und potenziell bereits ausgelöscht worden sein.

So kann sich die Zivilisation vor KI schützen

Auf die Frage, wie die Superintelligenz unsere Spezies auslösche könnte, nennt Garrett einige Möglichkeiten: die Entwicklung eines tödlichen Virus, die Behinderung der landwirtschaftlichen Nahrungsmittelproduktion und -verteilung, das Auslösen eines Krieges oder die Schmelzung eines Kernkraftwerks.

Gleichzeitig hebt Garrett auch den Nutzen von Künstlicher Intelligenz hervor. Er nennt beispielsweise verbesserte medizinische Bildgebung und Diagnose bis hin zu sichereren Verkehrssystemen. Regierungen sollten seiner Ansicht nach den Nutzen fördern und den Schaden begrenzen. Das Problem sei, dass die Regierungen unvorbereitet seien. Und wenn wir in dieser Lage sind, könnte das auch auf jede andere biologische Spezies zutreffen.

In seinem Paper unterstreicht Garrett die „…kritische Notwendigkeit, schnell einen regulatorischen Rahmen für die KI-Entwicklung auf der Erde und die Förderung einer multi-planetaren Gesellschaft zu schaffen, um solche existenziellen Bedrohungen abzumildern.“

Die Lösung: Menschheit soll auf andere Planeten expandieren

Garretts bisherige Analyse basiert auf der Annahme, dass die vermeintliche Superintelligenz und die Menschen denselben Raum bewohnen. Sollten wir allerdings den Status eines Multi-Planeten erreichen, würden sich auch die Aussichten ändern.

Eine biologische Spezies, die mehrere Planeten bewohnt, könne zum Beispiel unabhängige Erfahrungen auf verschiedenen Planeten nutzen, so Garrett. So könnte sie ihre Überlebensstrategien diversifizieren und möglicherweise das Scheitern einer an einen Planeten gebundenen Zivilisation vermeiden.

Wenn wir das Risiko also auf mehrere Planeten und mehrere Sterne verteilen würden, könnten wir uns möglicherweise gegen die schlimmstmöglichen Folgen von einer künstlichen Superintelligenz absichern – zumindest an einigen Standorten.

Wer den Prognosen für den Planet Erde glaubt, könnte Garrett in seinen Überlegungen zumindest teilweise Recht geben. Allerdings befürchtet der Wissenschaftler auch, dass die Menschheit mit der Auswanderung auf andere Planeten nicht so schnell vorankommt, wie sich Künstliche Intelligenz entwickelt. Vielleicht könnte die KI uns dabei helfen?

Auch interessant:

- Dr. ChatGPT: “Sag mir, was ich hören will” – Vorsicht vor Selbstdiagnose mit KI

- Mit KI: Google will offenbar kostenpflichtiges Abo für seine Suche einführen

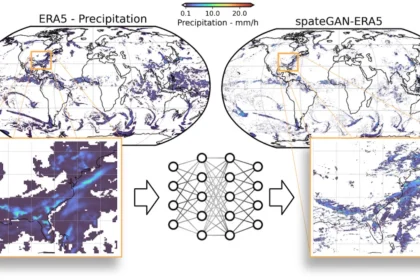

- Künstliche Intelligenz kann Flutkatastrophen vorhersagen – präziser als je zuvor

- TacticAI: Künstliche Intelligenz als Taktik-Assistent im Fußball