In den USA hat ein Auto einen Fußgänger überfahren. Das ist tragisch, ohne jede Frage. Und, ebenso tragisch: Allein in den USA sterben jeden Tag mehr als 100 Menschen im Straßenverkehr, darunter ungefähr 16 Fußgänger.

Das besondere an dem aktuellen Fall: Es saß kein Mensch am Steuer, sondern eine Maschine. Also, bei genauer Betrachtung saß ein Mensch hinter dem Steuer – der ist aber nicht gefahren, sondern war ein Sicherheitsfahrer, das Auto wurde von einem Computer gesteuert.

Nachdem klar war, dass es sich um ein sogenanntes „selbstfahrendes Auto“ gehandelt hat, das in den Unfall verwickelt war, ist ein wahrer Orkan von Aufmerksamkeit losgetreten wurden. Wie in unserer Zeit leider üblich wird in solchen Fällen nicht abgewartet, bis alle Daten ausgewertet wurden. Stattdessen wird jede neue Information sofort in die Welt posaunt und alle mögliche Experten melden sich umgehend zu Wort. Ich persönlich denke, das wir in einer Hype-Gesellschaft leben. Das heißt, wir schwingen uns von Hype zu Hype. Der Sensationshunger der Meute ist unersättlich und die Medien versuchen sich gegenseitig zu übertreffen. Dabei bleiben Fakten gerne mal auf der Strecke bzw. ändern sich.

Im Fall des tödlichen Unfalls in Tempe (Arizona) hat es in den vergangen beiden Tagen ein Hin und Her von sich teilweise widersprechenden Informationen gegeben. Schon der Umstand, dass sich die Geschwindigkeit, mit dem das Fahrzeug zum Zeitpunkt des Unfalls angeblich unterwegs war, im Laufe der Stunden von 45mph auf35 mph auf ~40mph verändert hat zeigt, wie schwierig es ist, bei diesem Ereignis die Übersicht zu behalten.

Bin ich ein Arschloch?

Diese Frage habe ich mir gestellt, nachdem ich den Artikel von Bernd auf unserem Blog gelesen habe. Über (nicht) “autonome” Autos, völlig überforderte Behörden, Medien und “Technikversteher“. Dort kommt er unter anderem zu diesem Fazit:

Das Fazit ist: Die Frau ist tot, und sie müsste es definitiv nicht sein. Wer sie als tragisches, aber eben “notwendiges” Opfer auf dem Weg zu einem sicheren Straßenverkehr für Viele betrachtet ist ein Zyniker, um nicht zu sagen: ein Arschloch. Zieht euch den Schuh gerne an, wenn er passt.

Ich persönlich stimme mit vielen Ansichten von Bernd in seinem Artikel nicht überein. Bei dem Fazit musste ich kurz in mich gehen und noch einmal reflektieren, ob ich deshalb ein Arschloch bin.

In jedem Fall finde ich es bedauerlich, dass die Frau bei dem Unfall gestorben ist. Aber genau so bedauerlich finde ich eigentlich jeden Unfall mit Todesfolge. Aber in Anbetracht der Tatsache, dass jeden Tag tödliche Unfälle im Straßenverkehr passieren – und, seien wir mal ehrlich, das ist bei weitem nicht das Schlimmste, was bei uns auf der Welt jeden Tag passiert – kann ich diesem Unfall keinen besonders erhöhten Stellenwert zukommen lassen.

Ja natürlich ist es was Besonderes, dass diesmal ein Computer das Fahrzeug gesteuert hat. Anscheinend treibt viele Medien deshalb zur Zeit besonders eine Frage an:

Wer hat denn nun Schuld ?

Ich möchte an dieser Stelle festhalten, dass die Schuldfrage noch nicht endgültig geklärt ist. Im Moment wird der schwarze Peter munter zwischen Auto, Fußgänger und Testfahrer hin und hergeschoben. Eigentlich habe ich lange um dieses Ereignis einen Bogen machen wollen, zumindest bis ein endgültiges Ergebnis der Untersuchungen vorliegt.

Das Auto?

Tatsächlich bin auch ich sehr verwundert, dass das Auto den Unfall nicht verhindert hat. Ich bin sehr gespannt, was bei den Untersuchungen als Ergebnis herauskommt, denn es dürfte sich um einen der am besten dokumentierten Unfälle dieser Art handeln. Das Auto wird noch eine ganze Reihe an weiteren Daten haben, die bis jetzt noch nicht ausgewertet wurden.

Der Sicherheitsfahrer?

Oft habe ich in den vergangenen Tagen gelesen, dass dem menschlichen Fahrer die Schuld gegeben wird. Ich kann mir kaum vorstellen, dass der Fahrer die Frau gesehen hat (oder erst zu spät). Denn egal wie „autonom“ das Testfahrzeug auch ist: Als jemand, der selbst oft genug teilautonome Fahrzeugen fährt, bin ich mir sicher, dass kein Mensch tatenlos sein Auto auf einen Unfall zusteuert. Mir ist natürlich klar, dass man als Mensch leicht ablenkbar ist, aber das ist ein Risiko, dass wir alle im Straßenverkehr akzeptieren. Vielleicht hätte der Fahrer den Fußgänger sehen können, in dem Video wirkt es so als ob er mit dem Radio beschäftigt wäre. Eine Situation die jeder von uns wahrscheinlich selber schon mal erlebt hat. Hier müsste man auf jeden Fall die Frage klären, ob ihn daher eine (Mit-)Schuld trifft.

Die Fußgängerin?

Auch erwähnen will ich die Fußgängerin, die eventuell eine Mitschuld treffen könnte. Denn: Sie hat die Straße nicht an einem Fußgängerübergang überquert. Ich selbst und viele unserer Leser haben so etwas bestimmt auch schon mal gemacht. Wenn ich eine Straße überquere, wo ich es eigentlich nicht darf, würde ich persönlich mich immer extrem beeilen und nie davon ausgehen, dass das Auto mich schon sehen wird.

Juristische Abwägung

Wenn dieser Unfall einem Menschen passiert wäre, würde dieser Fall bei uns mindestens als „Fahrlässige Tötung“ betrachtet. In Deutschland würde ist das der §222 StGB:

Wer durch Fahrlässigkeit den Tod eines Menschen verursacht, wird mit Freiheitsstrafe bis zu fünf Jahren oder mit Geldstrafe bestraft.

Nach Rücksprache mit einem Juristen habe ich erfahren, dass dies bei einem unbescholtenen Bürger in vergleichbaren Fällen meist mit einer Strafe auf Bewährung oder einer Geldstrafe bestraft wird. Ich könnte mir gut vorstellen, dass dieser Ansatz bei dem konkret verwendeten System auch angewendet werden könnte.

Was lernen wir daraus?

Mich persönlich ärgert es enorm, dass ich mich in den Strudel der Schuldfrage, aus dem ich mich eigentlich heraushalten wollte, nun doch noch mit ‚reingezogen wurde. Denn erst der Abschluss der Untersuchung wird zeigen, was genau passiert ist. Alles vorher sind nur Mutmaßungen.

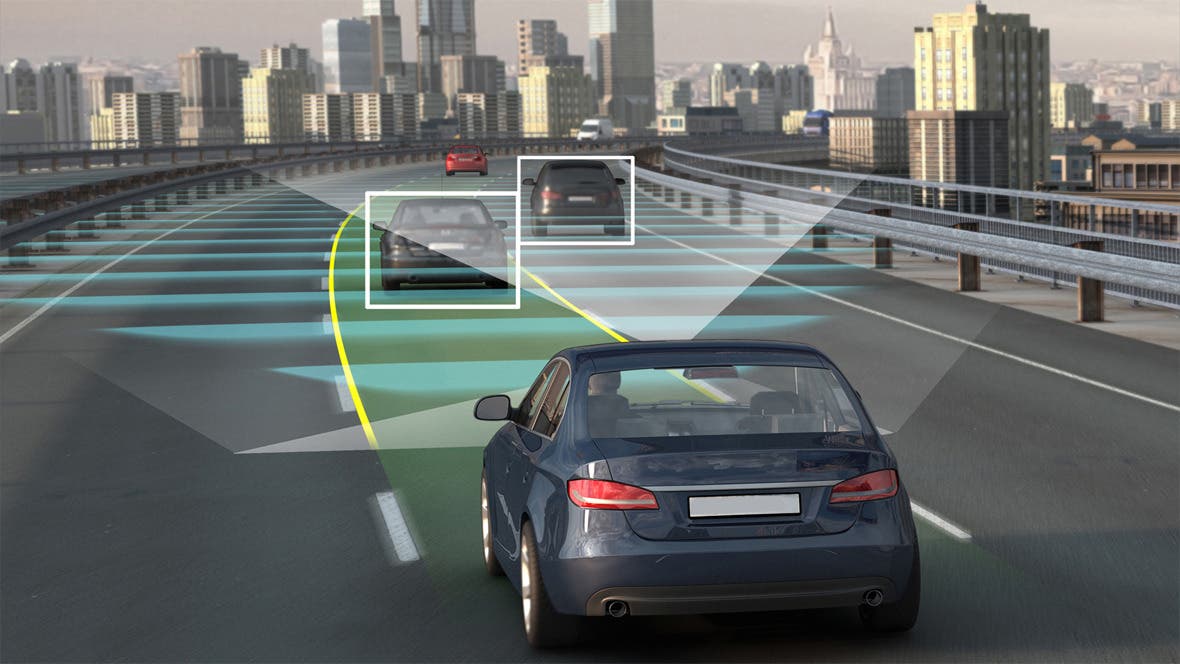

Viele Experten sind jetzt schon der Ansicht, dass die Schuldfrage geklärt sei und berufen sich nach aktueller Faktenlage darauf, alles deute darauf hin, dass das Auto die Schuld trage. Ich finde diese absoluten Aussagen sehr gewagt. Erst wenn alle Sensordaten ausgewertet werden, können wir uns ein endgültiges Bild machen. Ich erwähnte ja schon zuvor, dass ich verwundert bin, dass das Auto den Unfall nicht verhindert hat. Es ist eigentlich nahezu unmöglich, dass die Kombination von Sensoren – allem voran LIDAR und Radar – die Fußgängerin nicht registriert haben sollen. Jedes System für sich selbst sollte dazu bereits in der Lage sein. Daher bleiben für mich noch einige Fragen offen, warum genau es zu dem Unfall gekommen ist.

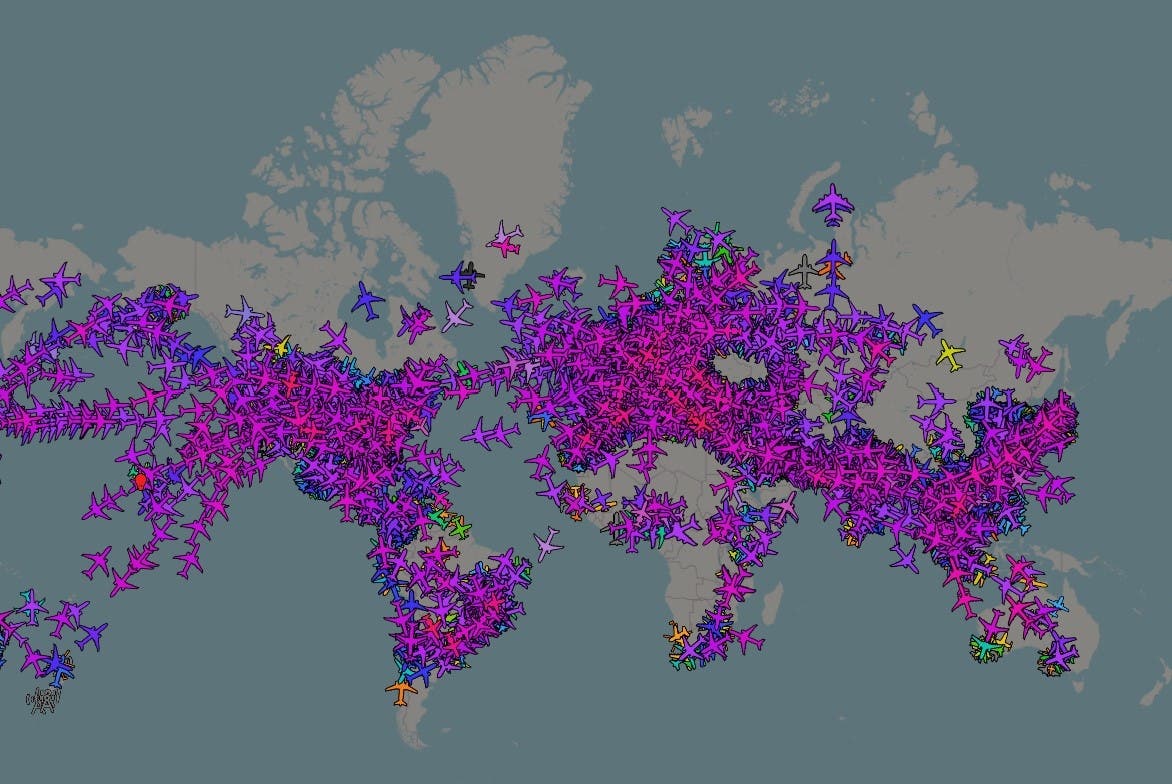

Ich persönlich kann mich auf keinem Fall der Meinung anschließen, dass jetzt weitere Testfahrten von anderen ähnlichen System gänzlich untersagt werden sollten. Es ist absolut richtig, dass Uber seine Testfahrten eingestellt hat. Aber aufgrund eines Unfalls kann man jetzt nicht eine ganze Technologie in Sippenhaft nehmen. Mit dieser Einstellung würden wir heute nämlich wohl kaum in ein technisches Fortbewegungsmittel einsteigen, egal ob Flugzeug, Zug oder Fahrstuhl.

Auch die Aussage, dass man noch viel mit Simulationen arbeiten müsse, bevor die Autos auf die Straße dürften erscheint mir nicht sinnvoll. Das wahre Leben passiert nicht in einer Simulation, bzw. kaum eine Simulation wird meiner Ansicht nach in der Lage sein, alle möglichen Szenarien zu erfassen. Trotz einer hohen Anzahl von Simulationen kann es in technischen Systemen zu einer Verkettung von extrem unwahrscheinlichen Problemen kommen, die in der Summe dann zu einem großen Ereignis führen. Damit möchte ich nicht andeuten, dass man mit Simulationen aufhören sollte.

Ich kann mir kaum vorstellen, dass die Entwickler die Möglichkeit von Fußgängern im Straßenverkehr nicht berücksichtigt haben. Daher bin ich gespannt, was bei den Untersuchungen herauskommt und was man daraus lernen wird. Aber: Dies wird sicher nicht der letzte tödliche Unfall eines autonomen Fahrzeuges sein. 100%-ige Sicherheit wird es niemals geben. Deshalb bin ich der Meinung, die Technik sollte auch weiterhin im Straßenverkehr benutzt werden.